Llegas a una ciudad que no has visitado nunca y te diriges a la oficina de Turismo para que te recomienden los barrios que deberías visitar y aquellos que, por el contrario, es mejor no pisar. Has llegado a un gigantesco parque de atracciones y buscas un punto de información para obtener un plano que te facilite moverte por todas sus instalaciones… Siempre vamos en busca de referencias que nos permitan transitar de forma segura en sitios desconocidos, ¿lógico verdad? Pues Google funciona igual. Busca las instrucciones que deben seguir sus arañas para moverse por una página web de forma eficaz y dónde las encuentra, en el robots.txt.

Si quieres saber qué es el robots.txt, cómo interpretarlo y optimizarlo, y curiosidades sobre este archivo, tienes que quedarte hasta el final. Te lo contamos todo en este post.

¿Qué es el robots.txt de mi web?

Como su propia extensión indica, el robots.txt es un archivo de texto que se sube a la carpeta raíz de tu sitio web. Su función no es otra que la de indicar a los buscadores qué páginas del sitio puede rastrear y cuáles no. Si tu sitio web tiene miles de urls resulta especialmente interesante saber qué es el robots.txt y cómo optimizarlo ya que, por el contrario, los centenares de solicitudes enviadas por los buscadores para rastrear tu sitio cada día pueden terminar sobrecargando el servidor y colapsando tu web. Te lo contamos más adelante.

¿Cómo optimizar el robots.txt?

Para poder optimizar el robots.txt de un sitio web, es importante que, primero, entiendas su sintaxis. Principalmente, encontrarás 5 términos con los que debes familiarizarte para saber interpretar y, posteriormente optimizar, las instrucciones que le estás facilitando a los bots. Vamos allá.

User-agent:

Suele ser la primera línea que aparece en un robots.txt. ¿Por qué? Muy sencillo, a través de esta línea estarás avisando a qué buscadores afectan tus instrucciones. Si quieres que vayan dirigidas a todos los rastreadores deberás incluir un asterisco tras el user-agent.

User-agent:*

Si has creado el archivo con intención de que lo interprete solo Google, debes incluir un user-agent: Googlebot. Si además quieres que las directrices sean interpretadas por Bing, entonces debes añadir un user-agent: Bingbot. Además, puedes referirte a los bots de diferentes herramientas SEO como Semrush o Ahrefs para que obedezcan tus directrices, en este caso, lo puedes indicar a través de un user-agent: semrushbot o user-agent: ahrefsbot, por ejemplo.

Disallow:

El disallow es una orden muy sencilla de interpretar. A través de él le estarás indicando a los buscadores lo que no quieres que rastreen. Actúa como un cortafuegos. De esta forma, si encuentras en tu robots.txt un disallow: / le estarás dando la orden a los bots de que no rastreen o accedan a ninguna página de tu sitio web. Esta indicación suele darse cuando las páginas están en desarrollo y no queremos que Google las rastree todavía. Dicho esto, es muy importante recordar eliminarla una vez finalizada la web si queremos que Google la indexe y lograr resultados SEO.

Seguro que en muchos robots.txt has visto las siguientes indicaciones:

Disallow: /wp-admin/

Disallow: /area-cliente/

Disallow: /login/

Es una forma de pedirle a los bots que no rastreen páginas de acceso a paneles de control privados y de escaso valor para el usuario.

A través de esta orden también puedes solicitar a los buscadores que no rastreen determinadas categorías de tu web. ¿Cómo?

Disallow: /nombre-de-la-categoria/

¿Fácil verdad?

Allow:

A través del Allow, al contrario que con el Disalow, estarás indicando a los crawlers o bots las páginas que deben rastrear. No suele utilizarse mucho ya que, por defecto, si no das una orden concreta de disallow, Google y el resto de robots rastrearán todas las urls de tu web.

Si configuras un robots.txt muy complejo en cuanto a número de instrucciones, debes de tener cuidado de que una línea no contradiga a otra anterior. Si esto sucediera, ante una orden contradictoria, Google prioriza la cadena más larga o la orden más concreta. Por ejemplo:

Disallow: /nombre-de-la-categoria/

Allow: /nombre-de-la-categoria/*nombre-de-producto/

En este caso, aunque le hayas dicho a Google que no rastree nada de una determinada categoría y que sí rastree un producto incluido dentro de la misma, Google obedecerá el Alow puesto que es la orden más precisa.

Crawl Delay

Hemos llegado a un parámetro que si bien no te lo vas a encontrar en todos los robtos.txt y no haga falta en el tuyo, es muy necesario para aquellos que tengan una gran dimensión o que estén expuestos a rastreos de crawlers maliciosos. Hablamos del crawl delay.

User agent: msnbot

Crawl delay: 60

Con este parámetro estás indicando al robot de msn que entre una solicitud de rastreo y otra debe dejar pasar, al menos, 60 segundos. Como comentábamos, es de gran utilidad para evitar que los rastreos maliciosos realizados de forma masiva sobrecarguen el servidor de tu web y termine caída. Es importante tener en cuenta que Googlebot ignora esta directriz puesto que existe la forma de definirle la velocidad de rastreo de tu sitio web directamente a través de la configuración de Search Console.

Pero user-agent, disallow, allow y crawl delay no es la única sintaxis que encontrarás o que te hará falta utilizar en un archivo robots.txt. El asterisco (*), el símbolo del dólar ($) y la almohadilla (#) son otros elementos útiles que te ayudarán a elaborar las instrucciones de rastreo.

* Como ya hemos comentado, si ves el asterisco tras el user-agent estarás indicando que las indicaciones posteriores afectan a todos los crawlers o bots de rastreo. Pero si sitúas el asterisco en una url de un disallow, estarás solicitando que no rastreen ninguna página que contenga lo que está justo detrás de él. Por ejemplo: ante un disallow:/blog/*? Google y el resto de bots entienden que no deben rastrear ninguna url que finalice en interrogación.

$ El símbolo del dólar, sin embargo, se utiliza para frenar cadenas. Si incluyes un disallow:/blog/ los bots no rastrearán nada de tu blog pero si pones un disallow:/blog/$ no va a rastrear exactamente la url /blog/ pero sí /blog/titulo-del-articulo/ y las urls de todas tus entradas del blog.

# Si elaboras un robots.txt muy complejo puedes hacer apuntes a nivel interno, que los robots no interpreten pero que para ti sean de gran utilidad. Por ejemplo: #Urls de Páginas privadas y a continuación indicas los disallow para las urls de áreas privadas. #Urls de riltros y a continuación creamos todos los disallow necesarios para que Google no rastree las variables que se generen en una url de filtro de producto.

Sitemap dentro del robots.txt, ¿sí o no?

Parece lógico pensar que incluir dentro del primer archivo que van a visitar los crawler un mapa del sitio para facilitarles el camino es un gran acierto. Y así es. Esforzarse en tener un sitemap optimizado sin incluirlo después en el archivo del robots.txt mermará los resultados de posicionamiento.

De cualquier modo, si tienes dudas, nada como visitar el robots.txt de los que realmente saben: google.es/robots.txt para saber que, si ellos lo incluyen, los demás debemos hacerlo.

Indexar y rastrear, no hablamos de lo mismo

Una vez que has llegado a este punto y que has entendido la funcionalidad del robots.txt y cómo los diferentes crawlers lo interpretan, debemos abordar un punto importante. La diferencia entre indexación y rastreo.

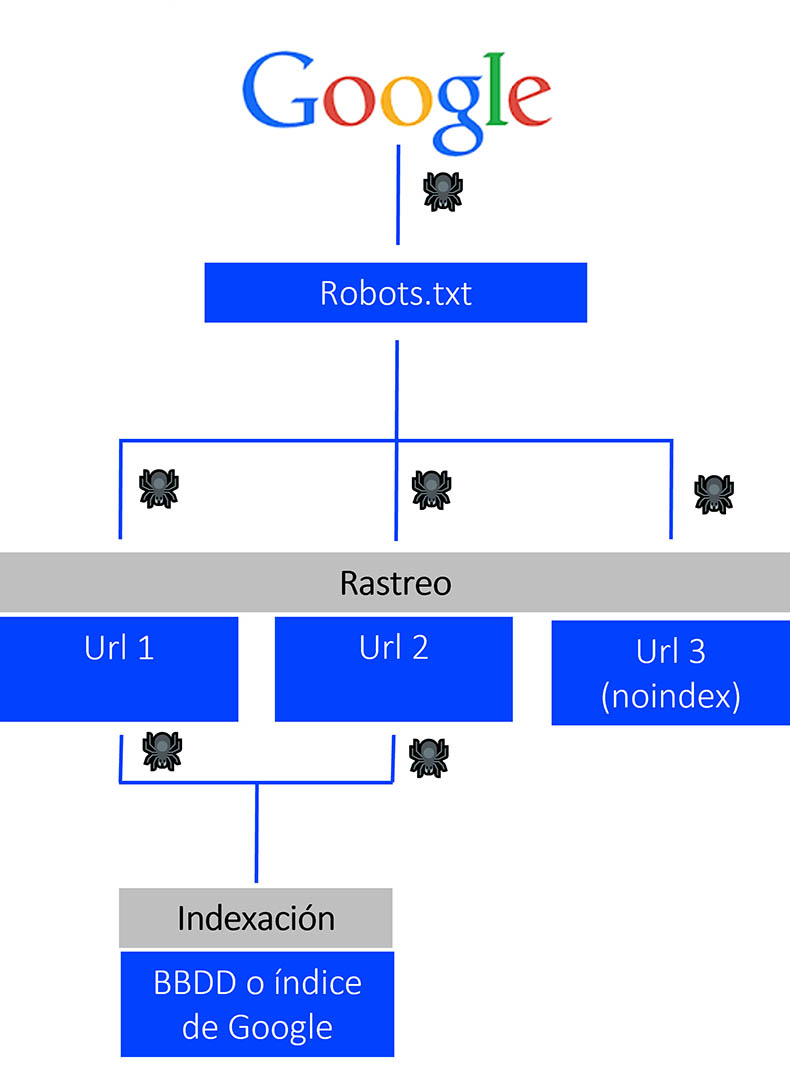

Google accede al robots.txt de tu página web y «suelta» sus spiders para que se adentren en todas las urls a las que puedan acceder según las directrices de tu archivo robot. Si en el análisis que las arañas hacen de las diferentes urls no se encuentran ninguna orden de no indexación, Google meterá estas urls en su índice o base de datos. Si por el contrario, Google encuentra una etiqueta meta con el parámetro noindex, entonces el rastreo habrá terminado ahí. Google no podrá indexar esta página en su base de datos.

Para entender aún mejor la diferencia, lo vamos a hacer a través de un sencillo caso práctico:

Tienes una página que en algún momento Google ha indexado pero quieres que Google ya no la muestre en sus SERP o páginas de resultados puesto que ya no aporta valor para los usuarios: tusitioweb.com/pagina-que-quiero-desindexar/. De este modo, dentro del <head> del código html de dicha página incluyes una instrucción que evita la indexación: <meta name= «robots» content=»noindex»>.

Para garantizar que Google no la muestre, decides además bloquear la url a través del robots.txt con un disalow:

User-agent: *

Disallow: /pagina-que-quiero-desindexar/

¡Error! Como hemos comentado antes, ante órdenes contradictorias, Google priorizará la más estricta. Si haces esto, estás impidiendo que Google rastree dicha urls y, ¿qué pasa si Google no la rastrea? Que no puede ver la meta noindex, por lo que seguirá mostrándola en sus páginas de resultados. Para que Google se tope con una meta de indexación, debemos permitirle el acceso a la página que la contiene.

Otro asunto importante a tener en cuenta. Lo que está bloqueado de cara a los crawlers a través del robots.txt no quiere decir que no sea visible a ojos del usuario. Las páginas no indexadas no se mostrarán en los resultados de búsqueda pero sí se puede acceder a ellas de forma directa incluyendo la url en la barra de navegación.

Excursión por los robots.txt más curiosos

No queríamos terminar este artículo con información tan técnica, sin enseñaros algunas de las curiosidades más divertidas que nos hemos encontrado en un archivo robots.txt. Allá vamos:

robots.txt de Youtube

Youtube nos dice en su robots que fue creado en un futuro lejano (el año 2000) después de que el levantamiento robótico de mediados de los 90 acabara con todos los humanos.

robots.txt de PC Componentes

El robots.txt de PC Componentes llama la atención no solo por su extensión kilométrica de líneas y líneas instructoras sino por la frase que han conseguido reproducir a través de barras.

robots.txt de Nike

A través de código también ha conseguido Nike reproducir en su robots.txt su seña de identidad más característica, su logo. Además, en el inicio del archivo podemos leer un just crawl it haciendo un guiño a su claim.

robots.txt de Casa Real

En el año 2010 fue muy sonado el caso Nóos, una trama de corrupción que salpicaba a Iñaki Urdangarín, todavía marido de la infanta Cristina. Pues bien, Casa Real tomó cartas en el asunto y quiso desvincularse de cualquier asunto que concerniera tanto al caso como a su protagonista y, ¿cómo lo hizo? A través del robots.txt. De esta forma, la web de la Casa Real indicaba a los bots que no podían rastrear las páginas en cuya url apareciera el apellido Urdangarín. A día de hoy ya no existe rastro de estas indicaciones.

En los años que llevamos optimizando robots.txt y curioseando cómo lo hace la competencia y las grandes marcas, hemos podido ver desde anuncios publicitarios hasta ofertas de empleo para SEOs publicadas en este archivo.

Llegamos al final del artículo recalcando la importancia que tiene prestarle la atención que merece a tu robots.txt y, para ello, lo mejor es dejarlo en manos de expertos en SEO. Recuerda que es el libro de instrucciones de rastreo para Google y que de él dependerán en gran medida los resultados del posicionamiento web de tu empresa.